導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的危險。科研人員表示:“很難避免我們可能在科學領域看到更多誠信問題的擔憂”...

在2020年底的COVID-19大流行期間,一些國家的病毒感染檢測試劑短缺。因此,利用一種已經廣泛使用的醫學技術——胸部X射線來診斷感染的想法聽起來很吸引人。盡管人眼不能可靠地區分感染和非感染個體之間的差異,但印度的一個團隊報告稱,人工智能(AI)可以做到,利用機器學習分析一組X射線圖像。[1]

這篇論文是關于這個想法的數十篇研究之一,已經被引用了900多次。但是到了次年的9月,堪薩斯州曼哈頓的計算機科學家Sanchari Dhar和Lior Shamir進行了更詳細的研究。他們在相同的圖像上訓練了一個機器學習算法,但只使用了完全不顯示任何身體部位的空白背景部分。然而,他們的人工智能仍然能夠在遠高于隨機水平的情況下識別出COVID-19病例。[2]

問題似乎是醫學圖像數據集中醫學圖像的背景存在一致的差異。一個AI系統可以捕捉到這些偽像,從而在診斷任務中取得成功,而不需要學習任何臨床相關的特征,使其在醫學上毫無用處。

Shamir和Dhar發現了其他幾種情況,其中據報告成功的AI圖像分類(從細胞類型到面部識別)在圖像的空白或無意義部分返回了類似的結果。這些算法在沒有面孔的情況下更勝于隨機地識別面孔,沒有細胞的情況下更勝于隨機地識別細胞。其中一些論文已被引用數百次。

Chest X-ray images of healthy people (left); those with COVID-19 (centre); and those with pneumonia (right).Credit: Healthy and Pneumonia: D. Kermany et al./Cell (CC BY 4.0); COVID-19: E. M. Edrada et al./Trop. Med. Health (CC BY 4.0).

Shamir表示,“這些例子可能很有趣”——但在生物醫學領域,錯誤分類可能是生死攸關的問題。“這個問題非常普遍——比我大多數同行想要相信的要多得多。”2021年的一項獨立回顧檢查了62項使用機器學習從胸部X射線或計算機斷層掃描中診斷COVID-19的研究,得出結論說,由于方法論缺陷或圖像數據集中的偏見,其中沒有一個AI模型在臨床上是有用的。[3]

Shamir和Dhar發現的錯誤只是機器學習在研究中產生誤導性聲明的一些方式。普林斯頓大學新澤西分校的計算機科學家Sayash Kapoor和Arvind Narayanan今年早些時候報告說,數據泄漏問題(當用于訓練AI系統的數據與用于測試它的數據之間沒有足夠的分離時)導致了他們檢查的17個領域中的再現性問題,影響了數百篇論文。他們認為,對AI的不當應用正在導致再現性危機。[4]

機器學習(ML)和其他類型的人工智能是強大的統計工具,通過挖掘對人類研究人員通常是看不見的數據中的模式,幾乎推動了科學的每個領域。與此同時,一些研究人員擔心對AI軟件的無知使用正在導致大量聲稱無法復制或在實際應用中是錯誤或無用的論文的涌現。

盡管還沒有對這個問題的范圍進行系統估計,但研究人員表示,從個例上看,充斥著錯誤的AI論文。“這是一個影響許多開始采用機器學習方法的社區的普遍問題,”Kapoor說。

佐治亞華盛頓大學的航空工程師Lorena Barba同意,幾乎沒有哪個領域能夠幸免于這個問題。“我有信心地說,在物理科學的科學機器學習中存在普遍問題,”她說。“而且這不是關于大量質量差或影響力低的論文,”她補充說。“我讀過很多發表在著名期刊和會議上的文章,與弱基線相比,夸大了論斷,未能報告完整的計算成本,完全忽略了工作的限制,或以其他方式未能提供足夠的信息、數據或代碼來復制結果。”

“有一種正確的方式來應用ML來測試科學假設,許多科學家從未真正受到過適當的培訓,因為這個領域仍然相對較新,”芝加哥德保羅大學的計算機方法在衛生研究中的專家Casey Bennett表示。“我看到很多常見的錯誤一遍又一遍地被重復,”他說。對于在健康研究中使用的ML工具,他補充說,“現在就像是荒野一樣。”

AI是如何誤入歧途的

與任何強大的新統計技術一樣,AI系統使尋找特定結果的研究人員很容易欺騙自己。“AI提供了一個工具,允許研究人員‘玩弄’數據和參數,直到結果與期望一致,”Shamir說。

“AI的不可思議的靈活性和可調性,以及在開發這些模型時的不嚴謹性,提供了太多的自由度,”加拿大多倫多大學的計算機科學家Benjamin Haibe-Kains說,他的實驗室將計算方法應用于癌癥研究。

根據Kapoor和Narayanan提出的分類方法,數據泄漏似乎特別普遍。ML算法在數據中訓練,直到它們可以可靠地為每個輸入產生正確的輸出,例如正確分類圖像。然后,在未見過(測試)數據集上評估其性能。正如ML專家所知,必須保持訓練集與測試集分開。但一些研究人員顯然不知道如何確保這一點。

問題可能是微妙的:如果從與訓練數據相同的池中取一個隨機子集作為測試數據,這可能導致泄漏。如果來自同一患者(或同一科學儀器)的醫學數據在訓練集和測試集之間進行拆分,AI可能會學習識別與該患者或該儀器相關的特征,而不是特定的醫學問題——例如在使用AI分析組織病理學圖像時識別的問題。這就是為什么Shamir說,在圖像的空白背景上進行“對照”試驗是至關重要的,這能用于查看算法生成的結果是否合乎邏輯。[5]

Kapoor和Narayanan還提出了測試集不反映現實世界數據時的問題。在這種情況下,一種方法可能在其測試數據上給出可靠和有效的結果,但在現實世界中無法復制。

“真實世界比實驗室中的變異要大得多,AI模型通常沒有經過測試,以適應這種變異,直到我們部署它們,”Haibe-Kains說。

在一個例子中,谷歌健康團隊在加利福尼亞州帕洛阿爾托的Google Health開發了一種AI,用于分析視網膜圖像以檢測糖尿病性視網膜病變的跡象,這可能導致失明。當Google Health團隊的其他人在泰國的診所中試用它時,由于該系統已經在高質量掃描上進行了培訓,它拒絕了許多在次優條件下拍攝的圖像。高拒絕率導致了與患者的更多隨訪面談——這是一種不必要的工作負擔。[6]

努力糾正訓練或測試數據集可能導致自身的問題。如果數據不平衡——即不均勻地采樣真實世界的分布——研究人員可能會應用重新平衡算法,如合成少數過采樣技術(SMOTE),它會為欠采樣區域生成合成數據。[7]

然而,Bennett表示,“在數據嚴重不平衡的情況下,SMOTE會導致對性能的過于樂觀估計,因為你實質上是基于對底層數據分布的不可檢驗的假設創造了大量的‘假數據’”。換句話說,SMOTE實際上并沒有平衡數據集,而是制造了充斥著與原始數據固有偏見相同的數據集。

即使是專家也很難避免這些問題。例如,2022年,法國數字科學和技術研究院(INRIA)的數據科學家Ga?l Varoquaux及其同事在巴黎發起了一個國際挑戰,要求團隊開發能夠從磁共振成像(MRI)獲取的腦結構數據準確診斷自閉癥譜系障礙的算法8。

該挑戰吸引了來自61個團隊的589份提交,而表現最佳的10個算法(主要使用ML)似乎在使用MRI數據時比使用基因型進行診斷的現有方法表現更好。但這些算法在另一個數據集上的推廣能力較差,該數據集被保密,不向團隊提供用于訓練和測試模型的公共數據。研究人員寫道:“對公共數據集的最佳預測過于美好,無法延伸到未見的私有數據集”。本質上,這是因為在小數據集上開發和測試方法,即使盡力避免數據泄漏,最終仍會過度擬合到這些數據,Varoquaux表示,即過于專注于與數據中的特定模式一致,以至于該方法失去了一般性。[8]

克服問題

今年8月,Kapoor、Narayanan和他們的同事提出了一種解決這個問題的方法,即制定了一個基于AI的科學報告的標準清單,其中包含32個問題,涉及數據質量、建模細節和數據泄漏風險等因素。他們表示,他們的清單“為ML-based科學的報告標準提供了跨學科的標桿”。其他清單已經為特定領域制定,如生命科學和化學。[9][10][11]

許多人認為,使用AI的研究論文應該完全公開其方法和數據。弗吉尼亞州分析公司Booz Allen Hamilton的數據科學家Edward Raff在2019年進行的一項研究發現,255篇使用AI方法的論文中只有63.5%能夠按照報告的方式進行復制,但后來蒙特利爾麥吉爾大學的計算機科學家Joelle Pineau等人表示,如果原始作者通過積極提供數據和代碼來幫助這些努力,復制率會提高到85%。考慮到這一點,Pineau和她的同事提出了一份使用AI方法的論文的協議,規定提交時必須包含源代碼,并且必須根據標準的ML可重復性清單進行評估。[12][13]

但研究人員注意到,在任何計算科學中提供足夠詳細的信息以進行完全可重復性都是困難的,更不用說在AI中了。

而且,清單只能做到這么多。可重復性并不保證模型提供正確的結果,而只是保證自洽的結果,荷蘭埃因霍溫科技大學的計算機科學家Joaquin Vanschoren警告說。他還指出,“很多真正高影響的AI模型是由大公司創建的,他們很少立即公開他們的代碼。”他說,有時人們不愿意發布自己的代碼,因為他們認為還沒有準備好接受公眾的審查。

盡管一些計算機科學的會議要求提供代碼才能發表同行評審的論文,但這并不是普遍的。Vanschoren表示,“最重要的會議對此更加認真,但這是一個復雜的問題。”

問題的部分原因可能是根本沒有足夠的數據可以正確測試模型。“如果沒有足夠的公共數據集,研究人員無法正確評估其模型,最終會發表顯示出很好性能的低質量結果,”亞馬遜AWS Health AI的科學家Joseph Cohen說,他還是美國非營利機構可重復研究研究所的主管。“這個問題在醫學研究中非常嚴重。”

對于生成式AI系統(如大型語言模型(LLMs))來說,可能存在的風險更大,這些模型可以使用從其訓練數據導出的模型生成新的數據,包括文本和圖像。例如,研究人員可以使用這些算法提高圖像的分辨率。但除非他們非常小心,否則可能會引入人為痕跡,谷歌位于加利福尼亞州山景城的研究科學家Viren Jain說,他致力于開發用于可視化和操作大數據集的AI。

“在顯微鏡領域,提高圖像質量,如去除噪聲,引起了很多興趣,”他說。“但我不會說這些事情是百分之百可靠的,它們可能會引入人為痕跡。”他在自己研究大腦組織圖像的工作中看到了這樣的危險。“如果我們不小心采取適當的步驟來驗證事物,我們可能很容易做出一些最終無意中導致不正確科學結論的事情。”

Jain還擔心濫用生成式AI的可能性,作為創建看似真實的科學圖像的一種簡便方法。“很難避免我們可能在科學領域看到更多誠信問題的擔憂,”他說。

文化轉變

一些研究人員認為,只有通過改變有關數據呈現和報告的文化規范,問題才能真正得到解決。Haibe-Kains對于實現這樣的變化并不太樂觀。2020年,他和他的同事批評了一項關于ML檢測乳腺癌的潛力的研究,該研究由Google Health的研究人員組成。Haibe-Kains及其合著者寫道,“由于缺乏足夠記錄的方法和支持該研究的計算代碼,該研究的科學價值受到了實質性的損害”,換句話說,由于沒有足夠的信息可以進行復制,該工作無法檢查。[14][15]

該研究的作者在一份已發表的回應中表示,由于部分數據來自擁有隱私顧慮的美國醫院,他們無權分享全部信息。他們補充說,他們“努力記錄所有相關的機器學習方法,同時確保文章對臨床和一般科學讀者可見”。[16]

更廣泛地說,Varoquaux和IT大學哥本哈根分校的計算機科學家Veronika Cheplygina認為,當前的出版激勵機制,尤其是產生引人注目標題的壓力,對基于人工智能的發現的可靠性構成了威脅。Haibe-Kains補充說,作者并不總是“本著善意的態度”遵守數據透明度準則,而期刊編輯在這方面通常沒有足夠的反擊。[17]

Haibe-Kains認為問題不在于編輯放棄透明度的規則,而在于編輯和審稿人可能“對分享數據、代碼等的真實和虛構障礙了解不足,因此他們往往滿足于非常膚淺、不合理的理由 [不分享此類信息]”。實際上,作者可能并不了解確保其工作的可靠性和可重復性需要什么。Bennett表示:“如果你不完全理解自己在做什么,要做到完全透明是很困難的。”

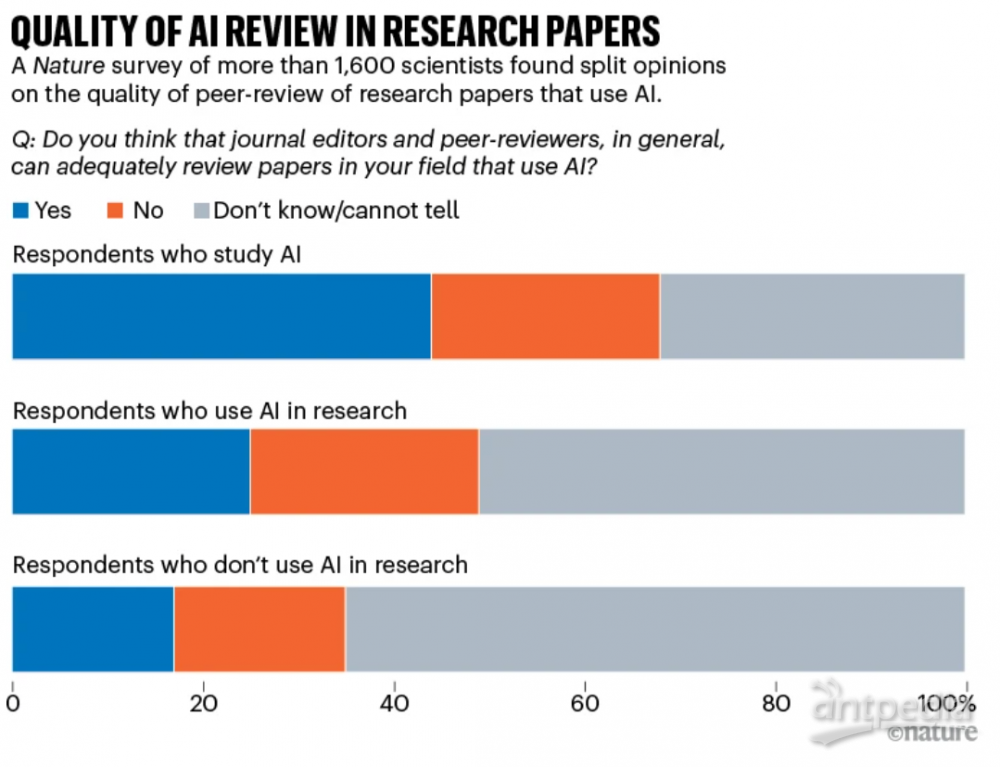

今年《自然》雜志進行的一項調查詢問了1,600多名研究人員對于AI相關期刊文章的同行評審是否足夠的看法。在那些使用AI進行工作的科學家中,有四分之一認為評論是足夠的,四分之一認為不夠,大約有一半表示不知道(見“研究論文中AI評論質量”和Nature 621, 672-675; 2023)。

Source: Nature 621, 672–675 (2023).

雖然有關個別論文存在大量潛在問題,但它們很少得到解決。個別案例往往陷入關于細節的爭論和反駁。例如,在Kapoor和Narayanan調查的一些案例研究中,涉及使用ML預測內戰爆發,他們聲稱結果被數據泄露扭曲的一些建議,得到了作者公開反駁(見Nature 608, 250–251; 2022)。而Dhar和Shamir批評的COVID-19胸部X射線識別研究的作者告訴《自然》雜志,他們不接受這些批評。

適應新的工具

并非每個人都認為人工智能危機正在逼近。“根據我的經驗,我還沒有看到人工智能應用導致無法重現結果增加的情況,”Helsinki Aiforia Technologies的神經科學家Lucas Stetzik說。事實上,他認為,經過謹慎應用,人工智能技術可以幫助消除常常滲透到研究人員工作中的認知偏見。“我之所以被吸引到人工智能領域,主要是因為我對許多方法無法重現以及一些不負責任的研究人員容易引導或挑揀結果的情況感到沮喪。”

盡管關于AI在科學文獻中使用的許多發現的有效性或可靠性存在廣泛的擔憂,但目前尚不清楚基于AI的文獻中的錯誤或不可靠的發現是否已經對例如臨床實踐中的誤診產生真正的危險。“我認為這有可能發生,我不會驚訝于發現它已經發生,但我還沒有看到任何這樣的報告,”Bennett說。

Cohen也認為問題可能會自行解決,就像其他新科學方法的初期問題一樣。“我認為事情最終會自然而然地解決,”他說。“發表質量低的論文的作者將受到研究界的負面評價,不會得到未來的工作。發表這些論文的期刊將被視為不值得信賴的,好的作者將不希望在其中發表論文。”

加利福尼亞州門洛帕克生物信息公司Enable Medicine的生物工程師Alex Trevino表示,確保以跨學科團隊的方式進行AI研究是使其更可靠的關鍵因素。例如,了解如何策劃和處理數據集的計算機科學家應與了解數據獲取的實驗復雜性的生物學家合作。

Bennett認為,在未來十年或二十年,研究人員將更加深入地了解AI可以提供什么以及如何使用它,就像生物學家花了那么長時間才更好地了解如何將基因分析與復雜疾病聯系起來一樣。Jain表示,至少對于生成式人工智能,當使用的模型更加一致時,可重現性可能會得到改善。“人們越來越傾向于基礎模型:像OpenAI的GPT-3和GPT-4這樣可以執行許多任務的非常通用的模型,”他說。這更有可能產生可重現的結果,而不是一些在內部訓練的定制模型。“因此,如果每個人都在使用相同的系統,你可以想象可重現性會有所提高。”

Vanschoren對航空航天工業進行了樂觀的類比。“在早期,這是非常危險的,經過幾十年的工程才使飛機變得值得信賴。”他認為人工智能將以類似的方式發展:“這個領域會變得更加成熟,隨著時間的推移,我們將了解哪些系統是值得信賴的。”問題在于研究界是否能在此期間解決這些問題。

《自然》624, 22-25 (2023)

doi: https://doi.org/10.1038/d41586-023-03817-6

引用:

Philip Ball is a science writer in London.

1. Khan, A. I., Shah, J. L. & Bhat, M. M. Comput. Methods Prog. Biomed. 196, 105581 (2020).

2. Dhar, S. & Shamir, L. Vis. Inform. 5, 92–101 (2021).

3. Roberts, M et al. Nature Mach. Intell. 3, 199–217 (2021).

4. Kapoor, S. & Narayanan, A. Patterns 4, 100804 (2023).

5. Oner, M. U., Cheng, Y.-C., Lee, H.K. & Sung, W.-K. Preprint at medRxiv https://doi.org/10.1101/2020.04.23.20076406 (2020).

6. Beede, E. et al. in Proc. 2020 CHI Conf. Human Factors Comput. Syst. https://doi.org/10.1145/3313831.3376718 (2020).

7. Chawla, N. V., Bowyer, K. W., Hall, L. O. & Kegelmeyer, W. P. J. Artif. Intell. Res. 16, 321–357 (2002).

8. Traut, N. et al. NeuroImage 255, 119171 (2022).

9. Kapoor, S. et al. Preprint at https://arxiv.org/abs/2308.07832 (2023).

10. Heil, B. J. et al. Nature Methods 18, 1132–1135 (2021).

11. Artrith, N. et al. Nature Chem. 13, 505–508 (2021).

12. Raff, E. Preprint at https://arxiv.org/abs/1909.06674 (2019).

13. Pineau, J. et al. J. Mach. Learn. Res. 22, 7459–7478 (2021).

14. McKinney, S. M. et al. Nature 577, 89–94 (2020).

15. Haibe-Kains, B. et al. Nature 586, E14–E16 (2020).

16. McKinney, S. M. et al. Nature 586, E17–E18 (2020).

17. Varoquaux, G. & Cheplygina, V. npj Digit. Med. 5, 48 (2022).

![]()

Is AI leading to a reproducibility crisis in science(AI是否正在導致再現性危機).pdf

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

導讀:關于使用AI的許多論文的有效性或可靠性存在許多潛在問題,但目前尚不清楚基于AI的科學文獻中的錯誤或不可靠的發現是否已經在實際臨床實踐中造成了真正的......

根據西班牙國家評估和認證機構(ANECA)的新提議,該國備受詬病的科學家評價體系將徹底改革。在舊體系中,學術職業發展的唯一評價標準是發表論文。據《科學》報道,上月宣布的這一改革舉措提出,將首次評估西班......

ZYCGR22011901公共技術服務中心第一批科研儀器設備采購項目,總金額2275.87萬元成交。詳細信息如下:一、項目編號:OITC-G230291679(招標文件編號:OITC-G2302916......

近日,知乎知學堂聯合電子工業出版社推出“對談凱文·凱利——AI的過去、現在與未來”直播,邀請《連線》雜志創始主編凱文·凱利與知乎CTO李大海等人連線交流,探討人工智能(AI)對當下的影響。面對AI技術......

近日,知乎知學堂聯合電子工業出版社推出“對談凱文·凱利——AI的過去、現在與未來”直播,邀請《連線》雜志創始主編凱文·凱利與知乎CTO李大海等人連線交流,探討人工智能(AI)對當下的影響。面對AI技術......